近日,第39屆神經信息處理系統大會(NeurIPS 2025)公布了錄用論文,上海電力大學副教授杜海舟團隊撰寫的論文《FedFree: Breaking Knowledge-sharing Barriers through Layer-wise Alignment in Heterogeneous Federated Learning》成功入選,這也是該團隊連續第二年在NeurIPS上發表分布式機器學習領域研究成果。

異構分布式機器學習中,異構模型訓練難以聚合收斂是整個過程的核心瓶頸問題。現有方法往往依賴代理數據或模型壓縮方法,其容易帶來隱私風險與知識傳遞不完整的問題。

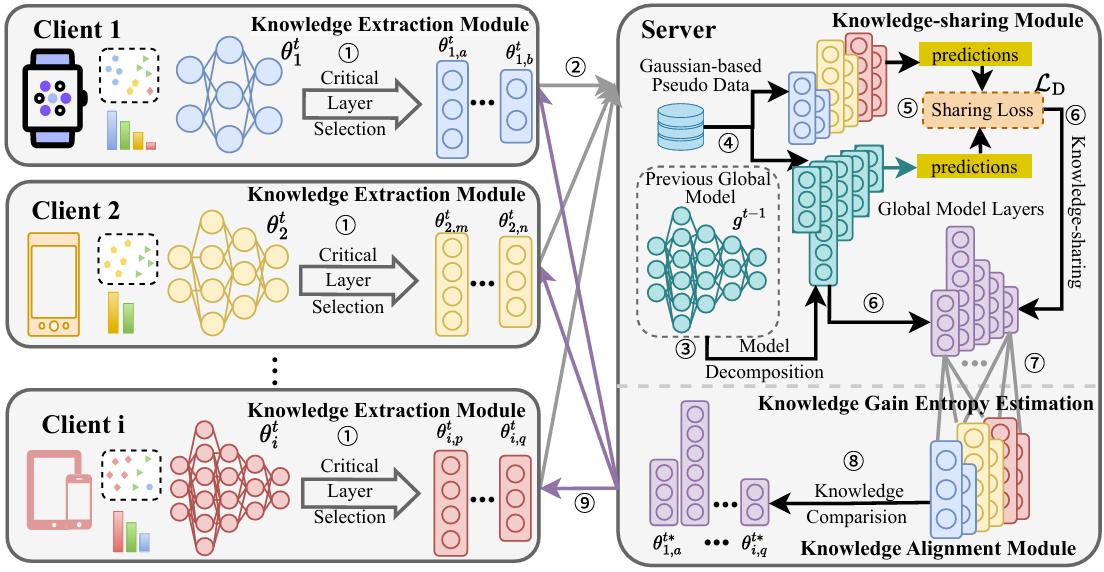

針對此問題,研究團隊提出了新框架FedFree,并通過逐層知識對齊機制,實現跨異構模型的數據無關知識共享。具體而言,FedFree 設計了逆向分層知識遷移機制與知識增益熵(Knowledge Gain Entropy, KGE)指標,在保證隱私安全的前提下,有效緩解了細粒度知識丟失問題,實現了跨異構設備的高效知識共享。理論分析與實驗結果表明,FedFree 不僅實現了嚴格的收斂性保證,而且在計算機視覺典型數據集上顯著優于現有方法,最高精度提升超過46%。

研究團隊表示,該研究成果應用場景廣闊,為構建面向大模型時代的高效、安全、普適的分布式智能系統提供了新路徑。

在基于無人機群的電力線路巡檢等領域,FedFree框架的數據隱私保護特性能夠有效提升異構識別模型整體性能;在邊緣計算場景中,FedFree框架不僅能夠提升異構設備間的協同建模能力,而且打破了異構設備之間的知識共享壁壘,為邊緣智能與隱私計算的深度融合提供了一條新方法;同時FedFree框架也為生成式人工智能時代的大小模型協同工作提供了一種新思路。

原文鏈接:https://rmtzx.sciencenet.cn/mixmedia/a/202510/03/WS68df7531e4b0cb2d1eeddf13.html